王选所师生参加EMNLP 2019

发布时间:2019-12-05

发布时间:2019-12-05

2019年11月3日至7日,自然语言处理实证方法会议(Conference on Empirical Methods in Natural Language Processing,简称EMNLP)在中国香港召开,北京大学王选计算机研究所赵东岩老师、万小军老师、冯岩松老师,研究生吴雨婷、高莘、汤济之参加了此次会议。

王选所师生在会场合影(左起:冯岩松,高莘,吴雨婷,汤济之,赵东岩)

EMNLP是自然语言处理领域的顶级国际会议,由国际计算语言学协会(ACL)的SIGDAT小组主办,每年举办一次,今年与IJCNLP(International Joint Conference on Natural Language Processing)联合举办。

本届会议共收到有效投稿2877篇,录用684篇,录用率为23.8%,其接收的论文覆盖了对话交互系统、信息抽取、信息检索、词法语义、机器翻译等自然语言处理领域众多研究方向。王选所师生在本次会议上共发表了6篇长文,1篇短文,分别针对了知识图谱实体对齐、文档摘要、知识图谱更新、文本生成、对话系统等任务进行了研究,并在会议上做了口头报告和海报展示。论文具体信息如下:

[1] Yuting Wu, Xiao Liu, Yansong Feng, Zheng Wang and Dongyan Zhao. Jointly Learning Entity and Relation Representations for Entity Alignment.

本文提出了一个基于图卷积神经网络的联合训练框架来同时实现异构知识图谱的实体对齐和关系对齐。该模型首先利用图卷积神经网络联合学习多个知识图谱的实体表示,利用实体表示去近似关系表示,并进一步构建包含邻居结构信息和周围关系信息的联合实体表示,最终实现实体对齐和关系对齐的相互促进。该模型在三个大规模跨语言的数据集上都达到了state-of-the-art的实验效果。

吴雨婷做海报展示

[2] Shen Gao, Xiuying Chen, Piji Li, Zhanming Chan, Dongyan Zhao and Rui Yan. How to Write Summaries with Patterns? Learning towards Abstractive Summarization through Prototype Editing.

本文提出一个可以利用现有文档与摘要对来学习一个摘要模板,从而生成符合模式化语言的文档摘要模型。为了提升模型生成的摘要与事实的一致性,本文提出使用一个局部和全局互信息估计器来增强生成摘要和原文档的事实一致性。同时本文还开放了一个大规模的数据集以便后续研究。实验结果表明,无论是自动指标还是人工测评,本文的模型相比于之前的方法都有显著的提高。

高莘做口头报告

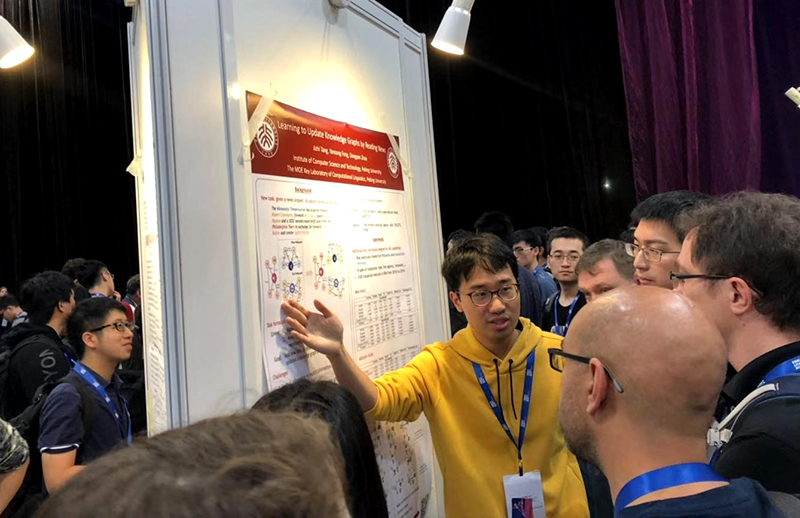

[3] Jizhi Tang, Yansong Feng, Dongyan Zhao. Learning to Update Knowledge Graphs by Reading News.

本文提出了一项新的任务:根据新闻文本更新知识图谱,发布了相应数据集NBATransactions,并提出一种新型的图神经网络模型GUpdater解决该问题。该模型通过注意力机制使模型能够根据文本内容控制图神经网络中信息的传递,实验证明GUpdater不仅能够理解新闻内容,还能捕获新闻的隐含信息,并且有效地更新知识图谱。

汤济之做海报展示

[4] Zhangming Chan, Xiuying Chen, Yongliang Wang, Juntao Li, Zhiqiang Zhang, Kun Gai, Dongyan Zhao and Rui Yan. Stick to the Facts: Learning towards a Fidelity-oriented E-Commerce Product Description Generation.

本文提出了一个面向真实性的产品描述生成模型FPDG。FPDG能够将商品关键词对应的实体信息作为一部分的额外输入信息,用来强化文本生成的先验,从而增强输入与输出之间的映射关系,让生成的文本更加的准确。实验结果证实了我们的模型的优越性。

[5] Zhangming Chan, Juntao Li, Xiaopeng Yang, Xiuying Chen, Wenpeng Hu, Dongyan Zhao and Rui Yan. Modeling Personalization in Countinuous Space for Response Generation via Augmented Wasserstein Autoencoders.

本文提出了改进用于对话生成的WAE模型,让其在捕捉到话语级信息的同时,对连续隐空间的用户级信息进行建模。通过将用户级和话语级信息嵌入到两个多模态分布中,并将这两个多模态分布合并为一个可生成更优的对话回复的混合分布。实验结果证实了我们的模型在对话回复生成方面的优越性。

[6] Ran Le, Wenpeng Hu, Mingyue Shang, Zhenjun You, Lidong Bing, Dongyan Zhao and Rui Yan. Who is speaking to whom learning to identify utterance addressee in multi-party conversations.

该论文提出并解决了对话系统中的一个新任务——根据一段多人对话(群聊)去识别每句话的指代对象,即每句话是说给谁听的。本文提出的W2W模型的表示学习模块对多人对话中的用户信息,聊天内容信息,以及二者之间的关系进行联合编码,匹配模块用来预测每句话的指代对象。W2W模型在有标注上的自动评测以及无标注上的人工评测中均取得了显著优于基线方法的效果。

[7] Jia Li, Chongyang Tao, Wei Wu, Yansong Feng, Dongyan Zhao and Rui Yan. Sampling Matters! An Empirical Study of Negative Sampling Strategies for Learning of Matching Models in Retrieval-based Dialogue Systems

该论文主要研究基于检索式对话系统的负采样策略。利用上一轮训练得到的模型为下一轮要训练的模型选取负样本的思想,实现四种负采样策略,提高了现有的检索式对话模型的效果。

上一篇 下一篇