王选所师生参加国际多媒体大会ACM MM 2025

发布时间:2025-11-10

发布时间:2025-11-10

2025年10月27日至31日,第33届ACM国际多媒体大会(ACM International Conference on Multimedia,ACM MM 2025)在爱尔兰都柏林召开。ACM MM是CCF A类推荐的国际多媒体领域顶级会议,涵盖多媒体内容理解、生成等多个核心研究主题,每年吸引全球科研院校与业界研究者参会交流。

1. 网络信息实验室博士后岳潭参加会议并进行口头报告,同时与参会同行深入交流。

Tan Yue, Xuzhao Shi, Rui Mao, Zilong Song, Zonghai Hu, Dongyan Zhao. "AnaFig: A Human-Aligned Dataset for Scientific Figure Analysis." Proceedings of the 33rd ACM International Conference on Multimedia. 2025.

论文简介:科学图表分析任务旨在结合背景知识的前提下,从图表中提炼关键规律并进行科学性解读。不同于仅关注表层视觉信息的传统图表描述生成任务,科学图表分析要求模型综合利用图像与文本输入,结合科学知识开展多模态理解与推理。本研究提出全新的科学图表分析数据集AnaFig,共包含来自56个领域的2000条高质量样本,并依据五维度标准人工标注10000个评分标签。该数据集可用于全面评估多模态大语言模型的指令遵循、多模态感知和分析性总结能力。通过构建基于主流多模态大语言模型的新基准,本研究为科学知识发现与分析推理提供了新的支撑,并推动模型在科学场景中更好地对齐人类专家水平。

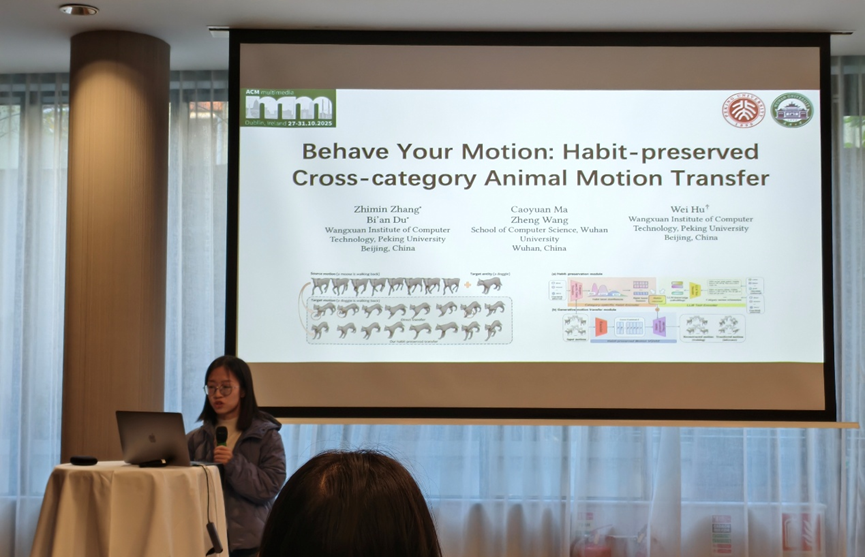

2. 数字视频研究室博士生张智敏的论文入选。“Behave Your Motion: Habit-preserved Cross-category Animal Motion Transfer”张智敏同学就其研究成果进行口头报告,并与国际同行展开深入交流与讨论。

该研究聚焦跨物种动物动作迁移任务,提出了一种能够保持不同动物独特行为习性的动作迁移框架,从而有效改进现有方法中动作内容与生物特性难以兼顾的问题。方法通过引入类别特定的习性编码模块,使模型能够学习并保留不同动物在运动中的独特行为习惯,此外,还引入了大语言模型作为外部知识库,进一步拓展了模型在未见过类别上的通用性和可扩展性。

3. 多媒体信息处理研究室共有4篇论文入选,信息如下:

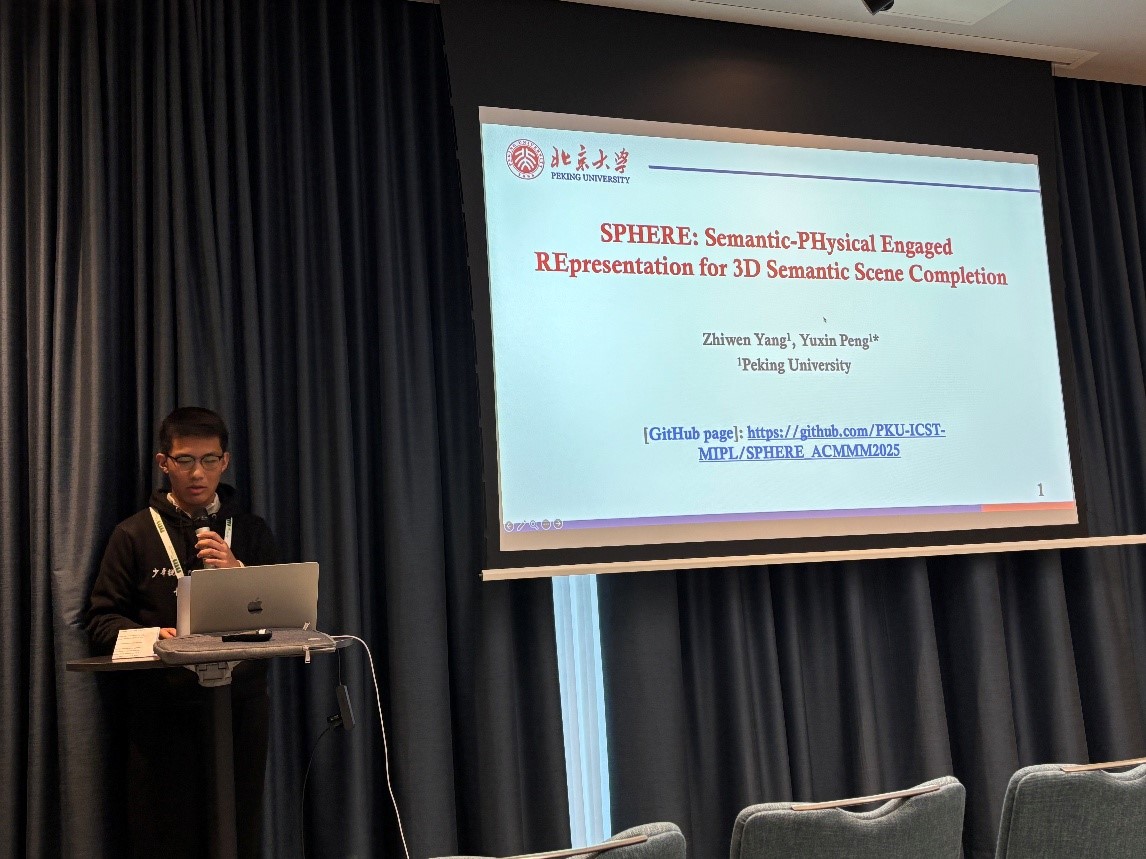

[1] Zhiwen Yang and Yuxin Peng*, "SPHERE: Semantic-PHysical Engaged REpresentation for 3D Semantic Scene Completion", The 33rd ACM International Conference on Multimedia (ACM MM), Dublin, Ireland, Oct. 27-31, 2025.

本论文针对语义场景补全 (Semantic Scene Completion, SSC) 中,单一表征方法难以兼顾精度和效率的问题,提出语义-物理联合表征三维占用预测 (Semantic-PHysical Engaged REpresentation, SPHERE) 方法。本方法主要包含两个阶段:(1)语义引导的高斯初始化,首先通过体素分支和三视图分支分别提取局部与全局语义特征,并根据两者的语义一致性筛选具有辨识性语义特征的关键锚点,引导高斯表征在关键区域的高效初始化;(2)物理感知的球谐增强,进一步将高斯语义表征投影到正交球谐空间,增强局部上下文几何结构信息建模,最后通过关键体素分布对齐促进语义-几何一致性,从而实现精度与效率兼顾的三维占用预测。

|

|

杨至文同学做报告展示

[2] Zhu Xu, Zhaowen Wang, Yuxin Peng and Yang Liu*, "Customized Human Object Interaction Image Generation", The 33rd ACM International Conference on Multimedia (ACM MM), Dublin, Ireland, Oct. 27-31, 2025.

本论文针对定制化图像生成仅关注目标外观、缺乏交互语义控制的问题,提出定制化人类物体交互图像生成任务(CHOI),需要保持人类与物体的身份特征并精确控制其交互语义。首先为解决身份特征与交互语义难以解耦的挑战,本文构建了一个大规模CHOI数据集,包含多姿态的同一人物对交互样本,用于支持身份与交互特征的解耦学习。为实现交互语义和身份定制能力平衡,设计了两阶段模型Interact-Custom,通过生成前景交互掩码以显式建模人物空间关系,并在掩码引导下实现身份定制。

[3] Zijing Zhao, Zhu Xu, Qingchao Chen, Yuxin Peng and Yang Liu*, "Investigating Domain Gaps for Indoor 3D Object Detection", The 33rd ACM International Conference on Multimedia (ACM MM) Dataset Track, Dublin, Ireland, Oct. 27-31, 2025.

本文针对3D室内场景目标检测在跨域迁移中性能下降的问题,提出了两个大规模仿真数据集和一套3D室内场景域适应目标检测基准。具体贡献如下:(1)数据集:构建了两个10k规模的仿真数据集ProcTHOR-OD和ProcFront,通过多样化场景布局和物体实例缓解数据稀缺问题,支持域适应任务研究;(2)跨域基准:结合真实与仿真数据,构建了包括ScanNet、SUN RGB-D等在内的全面基准,分析不同因素对检测任务的影响;(3)基线模型:提出了包括少量样本微调、物体大小先验和无监督适应等域适应方法,为提升跨域适应能力奠定基础。

[4] Wentao Mo, Qingchao Chen, Yuxin Peng, Siyuan Huang and Yang Liu*, "Advancing 3D Scene Understanding with MV-ScanQA Multi-View Reasoning Evaluation and TripAlign Pre-training Dataset", The 33rd ACM International Conference on Multimedia (ACM MM) Dataset Track, Dublin, Ireland, Oct. 27-31, 2025.

本文针对现有三维视觉语言(3D-VL)学习中的数据集瓶颈,提出了多视角基准测试、对齐多物体的预训练数据集及基线模型,以推动多视角、深层次三维场景理解的发展。具体贡献如下:(1)多视角问答基准(MV-ScanQA):构建了一个新数据集,有效测试多视角组合推理能力;(2)多物体对齐预训练语料库(TripAlign):提出了一个大规模2D-3D-语言三模态数据集,包含100多万个<2d视图, 3d="">三元组,显式对齐文本与多物体,增强模型对复杂场景的理解;(3)基线模型(LEGO):提出基线方法LEGO,结合预训练的二维视觉语言模型与TripAlign数据集,在MV-ScanQA等基准上取得最佳性能,验证了新数据集在提升三维视觉语言理解能力上的潜力。