计算机所师生参加IEEE ICME 2018

2018年7月23日至27日,计算机所郭宗明老师、刘家瑛老师,研究生徐晓烁赴美国圣地亚哥参加了2018年国际多媒体及博览会议(International Conference on Multimedia & Expo, ICME 2018)。该会议是由IEEE协会于2000年发起组织的多媒体领域旗舰会议,主要关注多媒体、智能分析与信号处理等领域最新的研究、应用和产品发布,具有很强的影响力。

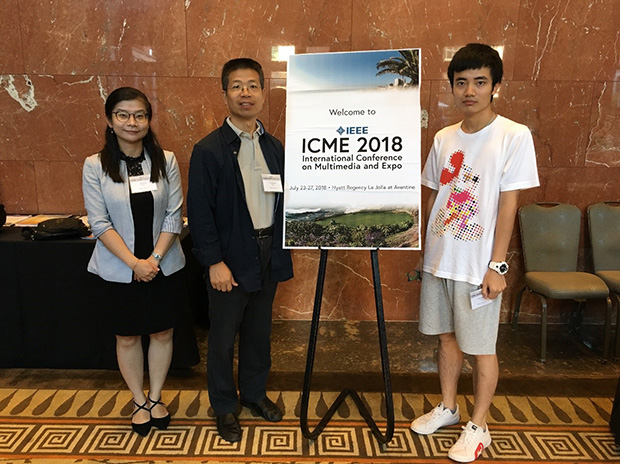

计算机所师生在ICME会场合影(左起:刘家瑛、郭宗明、徐晓烁)

本次会议包含Keynote、Tutorial、Lecture、Poster等多个环节。内容主要是多媒体信息处理,涉及视频编码、视频图像内容理解、网络传输等多媒体领域的各个方面。

计算机所师生在本次会议发表了4篇论文,分别针对虚拟现实视频传输、人体动作识别、翻唱版本鉴别、全景视频视点自适应传输进行了研究。前两篇进行了海报展示,第三篇论文进行了口头报告,第四篇论文参加了ICME Grand Challenge并取得第二名。论文的具体信息如下:

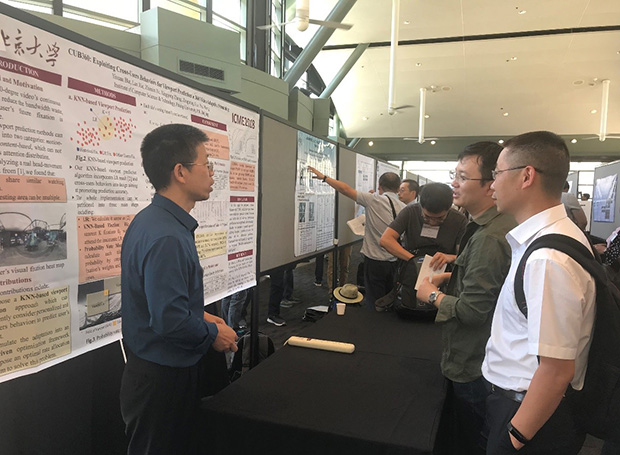

郭宗明老师(左一)在做海报展示

1)Yixuan Ban, Lan Xie, Zhimin Xu, Xinggong Zhang, Zongming Guo, “CUB360: Exploiting Cross-Users Behaviors for Viewport Prediction in 360 Video Adaptive Streaming”

本文致力于解决传统的虚拟现实视频传输方式中视点预测不准、视频内容质量差的问题。具体地,本文提出了一种基于K近邻的视点预测方法,旨在将个人观看行为与群体观看行为相结合,提升用户视点预测准确度。此外,本文还提出了一种最优化模型,旨在最大化用户期望视频质量的同时减少视频在空间上的抖动。为解决此优化问题,本文还提出一种新型的码率分配算法,旨在寻找出提升视频质量的最优解。经过大量的实验证明,本方法可以将视点预测准确度提升48.1%,同时将视频质量提升30.3%,明显优于现有的视频传输方案。

刘家瑛老师(左)和ICME大会主席Prof. C.-C. Jay Kuo(右)合影

2)Sijie Song, Cuiling Lan, Junliang Xing, Wenjun Zeng and Jiaying Liu, Skeleton-Indexed Deep Multi-Modal Feature Learning for High Performance Human Action Recognition

该论文在人体骨架数据的引导下,显式提取动作视频的细节信息,提升特征在动作识别任务中的判别力。同时,考虑不同数据模态(RGB,光流场,人体骨架)的互补性,该论文探索了不同的模态融合方式,极大提升了人体动作识别的精度。实验结果表明该论文提出的算法优于其他现有算法。

徐晓烁在做口头报告

3)Xiaoshuo Xu, Xiaoou Chen, Deshun Yang, KEY-INVARIANT CONVOLUTIONAL NEURAL NETWORK TOWARD EFFICIENT COVER SONG IDENTIFICATION

该论文搜集了大量的歌曲,训练key-invariant卷积网络用以提取音乐特征。同时,设计了一个算法用以加速检索。实验结果表明该方法在速度、准确度上优于其他方法。

许智敏的论文获得ICME Grand Challenge第二名

4)Zhimin Xu, Yixuan Ban, Kai Zhang, Lan Xie, Xinggong Zhang, Zongming Guo, Shengbin Meng and Yue Wang, "Tile-based QoE-driven HTTP/2 Streaming System for 360 Video", in IEEE ICME Grand Challenge on DASH, 2018.

该文章提出了一种基于分块的全景视频视点自适应传输框架,通过将一种等面积映射方式(SP)的全景视频作为输入,利用基于Cross-User的视点信息来提升用户视点预测的准确性,并利用了HTTP/2 Server Push特性来解决传输中效率低下等问题。该系统相比于已有的一些传输系统框架,取得了极大的性能提升。该方法在ICME Grand Challenge 2018取得Runner-up的成绩。

上一篇 下一篇