文档智能研究团队参加学术会议ICME2025并做论文报告

发布时间:2025-07-28

发布时间:2025-07-28

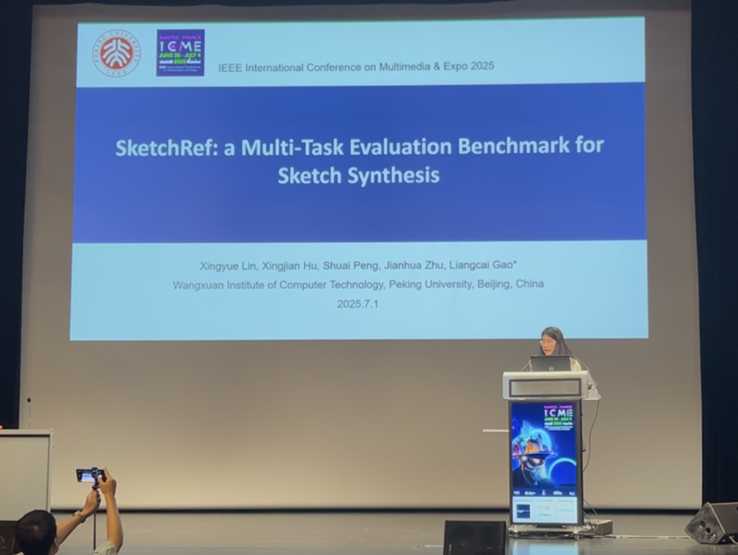

2025年6月30日至7月4日,多媒体技术领域的重要学术会议- IEEE International Conference on Multimedia & Expo,ICME2025在法国南特召开。王选所文档智能研究团队在此次会议上录用了2篇论文,博士生蔺星玥、彭帅代表研究团队参加了此次会议,并进行了相关论文展示和口头报告。

作为多媒体技术领域的国际权威会议,ICME2025在全球范围内吸引了广泛关注,共收到3737篇会议论文投稿。经过严格评审,共有1022篇会议论文被录用,录用率约27.3%。录取的会议论文中,511篇被选为口头报告(Oral Presentation),511篇以海报形式展示(Poster Presentation)。

汤帜研究员和高良才副教授带领的文档智能研究团队在本次会议上共发表2篇论文,包括1篇Oral论文,1篇Poster论文,论文具体信息如下:

[1] Xingyue Lin, Xingjian Hu, Shuai Peng, Jianhua Zhu, Liangcai Gao, SketchRef: a Multi-Task Evaluation Benchmark for Sketch Synthesis, ICME 2025.

该论文提出了首个多任务草图合成评估基准SketchRef,旨在解决当前草图合成领域缺乏统一评估标准的问题。研究者从人类、人脸、动物和常见物体四个领域收集数据,构建了包含类别预测和结构一致性估计两大任务的评估框架。论文创新性地引入了基于简化约束的识别率计算方法(mRS),量化了草图简化与可识别性之间的平衡,并通过7,920份艺术爱好者的反馈,验证了评估指标的有效性。实验评估了多种主流草图合成方法,发现现有方法在高简化水平下鲁棒性不足,且类别预测能力与结构一致性无必然关联,为未来草图合成优化提供了重要参考。

蔺星玥做口头报告

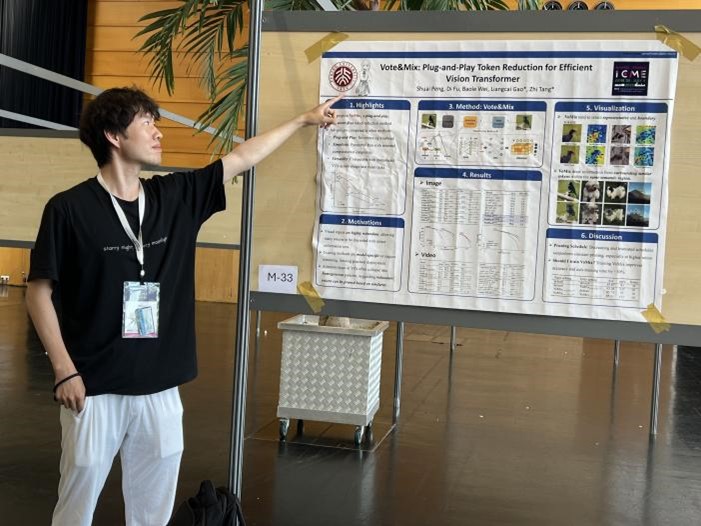

[2] Shuai Peng, Di Fu, Baole Wei, Yong Cao, Liangcai Gao, Zhi Tang, Vote&Mix: Plug-and-Play Token Reduction for Efficient Vision Transformer, ICME 2025

该论文提出了一种名为Vote&Mix(VoMix)的即插即用、无需训练的参数自由令牌缩减方法,旨在提升视觉Transformer(ViT)的计算效率。VoMix通过逐层的令牌相似性投票机制识别高同质性的令牌,并将其混合到保留的令牌集合中,从而在减少计算冗余的同时保留视觉信息。实验表明,VoMix在图像(如ImageNet-1K数据集)和视频(如Kinetics-400数据集)任务中显著改善了ViT的速度-准确率权衡。此外,VoMix无需微调即可直接应用于现有ViT模型,具有广泛适用性和高效性。

蔺星玥为同行讲解海报

彭帅讲解海报

上一篇 下一篇